来历:映维网 作者 黄颜

确认场景三维信息的才能称为深度感测,这对开发者和用户都是一项十分有价值的东西。深度传感是一个十分活泼的核算视觉范畴,近年来的立异包含人像形式和AR等运用,以及比如通明方针检测等根底感测立异。根据RGB的常见立体深度传感技能需求十分昂扬的核算,而且在低纹路区域会受必定的影响,而且在极低光照条件下会彻底失效。

因为Pixel 4的人脸解锁功用有必要以高速履行并支撑漆黑环境,所以它需求一种不同的处理放哪。Pixel 4的前端包含实时红外有源立体深度传感器uDepth。这项技能是Pixel 4的一项要害核算机视觉功用,有助于身份验证体系辨认用户,一起能够避免诈骗进犯。别的,它支撑一系列的新功用,如过后相片润饰、根据深度的场景切割、布景含糊、人像作用和3D相片等。

谷歌最近以Camera2 API的办法来供给了uDepth的拜访权限,答应运用Pixel Neural Core、两个红外摄像头和一个红外形式投影仪并以30Hz供给时刻同步的深度帧。Google Camera App运用这个API为Pixel 4用户的自拍带来优化的深度功用。在这篇博文中,谷歌将向我们概要解说uDepth的作业原理和底层算法,并用Piexl 4的示例成果对用例进行评论。下面是映维网的详细收拾:

1. 立体深度感测的总述

全部立体摄像头体系都会选用视差重建深度。关于这种作用,你能够凝视一个方针,闭合左眼,然后打开左眼并闭合右眼。你会发现方针的方位会呈现移动,而越挨近的方针移动得越快。uDepth是Dense Local Stereo匹配技能宗族的一员,其主要是经过核算来估量每个像素的视差。所述技能会在一个摄像头构成的图画中评价由每个像素围住的区域,并测验在第二个摄像头的相应图画中寻觅类似的区域。正确校准后,生成的重构归于可衡量,这在某种程度上预示着它们表明实践的物理间隔。

为了处理无纹路区域和处理弱光条件,团队运用了“有源立体”设置,将红外图画投影到由立体红外摄头机检测到的场景中。所述办法提高了低纹路区域的可辨认性,然后优化了辨认作用并降低了体系的核算量。

2. uDepth异乎寻常的当地

立体感测体系的运算量十分大。关于以30Hz频率运转的感测器,其在坚持高质量的前提下有必要是低功耗。uDepth使用了很多要害的见地来完成这一点。

其中之一是,给定一对互相类似的区域,而大多数对应的子集相同类似。例如,给定两个类似的8×8像素块,两者左上的4×4子区域相同或许类似。这将奉告uDepth管道的初始化进程,后者经过比较每个图画中的非堆叠像素块并挑选最类似的像素块来构建深度主张金字塔。这样的一个进程从1×1像素块开端,并按层累积支撑,直到生成初始低分辨率深度映射。

在初始化之后,团队运用一种全新的神经深度细化技能来支撑Pixel 4的规矩网格图画照冥具。典型的有源立体体系投射一个伪随机网格图画来协助消除场景中的匹配歧义,但uDepth能够支撑重复的网格形式。重复结构发生的区域在立体对中看起来十分类似,并或许会引起不正确的匹配。针对这样的一个问题,团队选用了轻量级卷积架构,经过红外亮度和附近信息来调整不正确的匹配,而每帧耗时不到1.5ms。

神经深度细化架构

在神经深度细化之后,适宜的深度估量将从相邻的像素块迭代传达。这个和后续的管道过程使用了uDepth成功的另一个要害洞悉:天然场景通常是部分平面,只要很小的非平面误差。这使得团队能够找到掩盖场景的平面像素块,然后只为一个像素块中的每个像素细化单个深度,然后大幅度削减核算负载。

最终,从相邻平面假定中挑选最佳匹配。

绿色组件由GPU运转,黄色组件由CPU运转,蓝色组件则由Pixel Neural Core运转

当手机呈现下跌状况时,这或许会导致立体摄像头的出厂校准违背实践方位。为了在实践运用中保证高质量的成果,uDepth体系支撑自校准。计分程序评价每个深度图画是不是真的存在误校准的痕迹,并树立对设备状况的决心。假如检测到校准过错,则从当时场景从头生成校准参数。

左面是未校准的立体深度;右边是经过自校准后的立体深度

更多的信息请参阅Slanted O(1) Stereo。

3. 用于核算拍摄的深度

uDepth传感器的原始数据需求是准确和可衡量,这是人脸解锁的基本要求。比如人像形式和三维相片等核算拍摄运用有着十分不同的需求。在所述用例中,完成视频帧速率并不重要,但深度应该是滑润的,边际对齐的,而且在五颜六色摄像头的整个视场中都是完好的。

从左到右:原始深度感测成果,猜测深度,3D相片

为了完成这一方针,团队练习了一个端到端的深度学习架构。它增强了原始uDepth数据,并推断出一个完好、密布的3D深度映射。谷歌选用了RGB图画、人像切割和原始深度的组合。

用于核算拍摄深度的架构

为了取得Ground Truth,团队使用了一个别三维捕捉体系。这是一个配备有331个自定义五颜六色LED灯、一组高分辨率色摄像头和一组自定义高分辨率深度传感器的测地线球体,能够生成挨近相片实在感的人像模型。谷歌在设置中添加了Pixel4智能手机,并将它们与其他硬件(灯光和摄像头)同步。生成的练习数据包含Pixel 4角度实在图画和组成烘托的组合。

数据获取总述

4. 将全部整合起来

当全部全部就位后,uDepth将能够以30Hz发生深度数据流,并生成滑润的后处理深度映射。体系生成的滑润、密布、每像素深度支撑启用Social Media Depth功用的全部Pixel 4自拍相片,而且可用于社会化媒体的散焦和3D相片等后期捕获作用。

谷歌最终供给了一个演示运用,这样你就可经过uDepth供给的实时点云可视化东西进行体会。请点击这儿下载(注,这个运用仅用于演示和研讨意图,不用于商业用途;谷歌不会供给任何支撑或更新)。这个演示运用会从你的Pixel 4可视化三维点云。因为深度映射归于时刻同步,而且与RGB图画坐落同一坐标系中,所以能够显现3D场景的纹路映射,如下面示例:

使用uDepth获取的单帧RGB点云示例

Arm Tech Symposia 年度技术大会:诠释面向 AI 的三大支柱,与生态伙伴

Arm Tech Symposia 年度技术大会:诠释面向 AI 的三大支柱,与生态伙伴 产业合作推动AI发展 高通孟樸:携手伙伴共抓5G+AI新机遇

产业合作推动AI发展 高通孟樸:携手伙伴共抓5G+AI新机遇 西门子2024 Realize LIVE用户大会:拥抱新质生产力,激发数智新动能

西门子2024 Realize LIVE用户大会:拥抱新质生产力,激发数智新动能 AI技术赋能内容生产全链路 芒果探索“文化+科技”的下一步

AI技术赋能内容生产全链路 芒果探索“文化+科技”的下一步 全国人大代表刘宏志:推动数字乡村建设、激发乡村振兴“数智力量”

全国人大代表刘宏志:推动数字乡村建设、激发乡村振兴“数智力量” 情人节不止214 DR钻戒将七夕情人节传至海外

情人节不止214 DR钻戒将七夕情人节传至海外 “E动新生 旗心共创” “航价比之王”红旗E-QM5专场团购会火热爆单

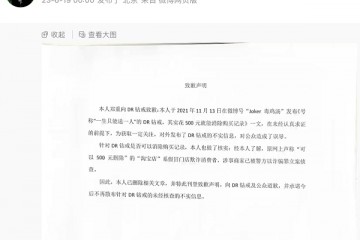

“E动新生 旗心共创” “航价比之王”红旗E-QM5专场团购会火热爆单 “DR购买记录可删”被证实是谣言,传谣者公开道歉

“DR购买记录可删”被证实是谣言,传谣者公开道歉 红旗新能源最新宠粉,E001首批盲订车主踏上“溯源之旅”

红旗新能源最新宠粉,E001首批盲订车主踏上“溯源之旅” 5月销量成绩瞩目 新能源战略引领红旗品牌再向上

5月销量成绩瞩目 新能源战略引领红旗品牌再向上