新智元报导

修改:张佳、大明、鹏飞

【新智元导读】多媒体世界尖端会议 ACM Multimedia 2019已于2019年10月21日至25日在法国尼斯举办。图神经网络在多媒体范畴运用十分多,本文整理了七篇ACM MM 2019最新GNN相关论文,并附上论文链接供参阅——个性化引荐、短视频引荐、多视频摘要、根据文本的行人查找、视频联系检测、社区问答(CQA)体系等。来新智元 AI 朋友圈和AI大咖们一同评论吧。

多媒体世界尖端会议 ACM Multimedia 2019已于2019年10月21日至25日在法国尼斯举办。图神经网络在多媒体范畴运用十分多,本文整理了七篇ACM MM 2019最新GNN相关论文,并附上论文链接供参阅——个性化引荐、短视频引荐、多视频摘要、根据文本的行人查找、视频联系检测、社区问答(CQA)体系等。

1. MMGCN: Multi-modal Graph Convolution Network for Personalized Recommendation of Micro-video

作者:Yinwei Wei,Xiang Wang,Liqiang Nie,Xiangnan He,Richang Hong,Tat-Seng Chua。

摘要:个性化引荐在许多在线内容同享平台中起着中心效果。为了供给优质的微视频引荐服务,重要的是考虑用户与项目(即短视频)之间的交互以及来自各种模态(例如视觉,听觉和文本)的项目内容。现有的多媒体引荐著作在很大程度上运用多模态内容来丰厚项目表明,而为运用用户和项目之间的信息交换来增强用户表明并进一步捕获用户对不同形式的细粒度偏好所做的作业却较少。在本文中,咱们主张运用用户-项目交互来辅导每种形式中的表明学习,并进一步个性化微视频引荐。咱们根据图神经网络的音讯传递思维规划了一个多模态图卷积网络(MMGCN)结构,该结构能够生成用户和微视频的特定模态表明,以更好地捕获用户的偏好。具体来说,咱们在每个模态中结构一个user-item二部图,并用其街坊的拓扑结构和特征丰厚每个节点的表明。经过在三个揭露可用的数据集Tiktok,Kwai和MovieLens上进行的很多试验,咱们证明了咱们提出的模型能够显着优于现在最新的多模态引荐办法。

网址:

https://dl.acm.org/citation.cfm?id=3351034

2. Routing Micro-videos via A Temporal Graph-guided Recommendation System

作者:Yongqi Li,Meng Liu,Jianhua Yin,Chaoran Cui,Xin-Shun Xu,Liqiang Nie。

摘要:在曩昔的几年中,短视频已成为社会化媒体年代的干流趋势。一起,跟着短视频数量的添加,用户常常被他们不感爱好的视频所吞没。虽然现有的针对各种社区的引荐体系现已取得了成功,但因为短视频平台中的用户具有其共同的特征:多样化的动态爱好,多层次的爱好以及负样本,因而它们无法运用于短视频的一种好的办法。为了处理这样一些问题,咱们提出了一个时刻图辅导的引荐体系。特别是,咱们首要规划了一个新颖的根据图的次序网络,以一起对用户的动态爱好和多样化爱好进行建模。相同,能够从用户的实在负样本中捕获不感爱好的信息。除此之外,咱们经过用户矩阵将用户的多层次爱好引进引荐模型,该矩阵能够学习用户爱好的增强表明。终究,体系能够终究靠考虑上述特征做出准确的引荐。在两个公共数据集上的试验成果证明了咱们提出的模型的有用性。

网址:

https://dl.acm.org/citation.cfm?id=3350950

3. MvsGCN: A Novel Graph Convolutional Network for Multi-video Summarization

作者:Jiaxin Wu,Sheng-hua Zhong,Yan Liu。

摘要:试图为视频调集生成单个摘要的多视频摘要,是处理不断增加的视频数据的重要使命。在本文中,咱们第一个提出用于多视频摘要的图卷积网络。这个新颖的网络衡量了每个视频在其自己的视频以及整个视频会集的重要性和相关性。提出了一种重要的节点采样办法,以着重有用的特征,这些特征更有或许被挑选作为终究的视频摘要。为了处理视频摘要使命中固有的类不平衡问题,提出了两种战略集成到网络中。针对多样性的丢失正则化用于鼓舞生成多样化的摘要。经过很多的试验,与传统的和最新的图模型以及最新的视频摘要办法来进行了比较,咱们提出的模型可有用地生成具有十分杰出多样性的多个视频的代表性摘要。它还在两个规范视频摘要数据集上达到了最先进的功用。

网址:

https://dl.acm.org/citation.cfm?doid=3343031.3350938

4. Deep Adversarial Graph Attention Convolution Network for Text-based Person Search

作者:Jiawei Liu,Zheng-Jun Zha,Richang Hong,Meng Wang,Yongdong Zhang。

摘要:新出现的根据文本的行人查找使命旨在经过对自然语言的查询以及对行人的详细描述来检索方针行人。与根据图画/视频的人查找(即人从头辨认)比较,它实际上更适用,而不需要对行人进行图画/视频查询。在这项作业中,咱们提出了一种新颖的深度对立图留意力卷积网络(A-GANet),用于根据文本的行人查找。A-GANet运用文本和视觉场景图,包含目标特点和联系,从文本查询和行人画廊图画到学习信息丰厚的文本和视觉表明。它以对立性学习的办法学习有用的文本-视觉联合潜在特征空间,弥合模态距离并促进行人匹配。具体来说,A-GANet由图画图留意力网络,文本图留意力网络和对立学习模块组成。图画和文本图形留意网络规划了一个新的图留意卷积层,能够在学习文本和视觉特征时有用运用图形结构,然后完成准确而有差异的表明。开发了具有特征转换器和模态鉴别器的对立学习模块,以学习用于跨模态匹配的联合文本-视觉特征空间。在两个具有应战性的基准(即CUHK-PEDES和Flickr30k数据集)上的很多试验成果证明了该办法的有用性。

网址:

https://dl.acm.org/citation.cfm?id=3350991

5. DoT-GNN: Domain-Transferred Graph Neural Network for Group Re-identification

作者:Ziling Huang,Zheng Wang,Wei Hu,Chia-Wen Lin,Shin’ichi Satoh。

摘要:大多数行人再辨认(ReID)办法的重点是从搜集的个人图画数据库中检索感爱好的人。除了独自的ReID使命外,在不同的摄像机视图中匹配一组人在监督运用程序中也起着及其重要的效果。这种组从头标识(G-ReID)使命十分具有应战性,因为咱们不只要面对个人外观改变所面对的妨碍,并且还要面对组布局和成员身份改变所面对的妨碍。为了取得集体图画的鲁棒表明,咱们规划了一种域搬运图神经网络(DoT-GNN)办法。长处包含三个方面:1)风格搬运。因为短少练习样本,咱们将符号的ReID数据集搬运到G-ReID数据集款式,并将搬运的样本供给给深度学习模型。运用深度学习模型的优势,咱们完成了可区别的个别特征模型。2)图生成。咱们将组视为图,其间每个节点表明单个特征,每个边缘表明几个个别之间的联系。咱们提出了一种图生成战略来创立满足的图形样本。3)图神经网络。运用生成的图样本,咱们练习GNN,以获取对大型图改变具有鲁棒性的图特征。DoT-GNN成功的关键在于搬运的图形处理了外观改变的应战,而GNN中的图表明克服了布局和成员资历改变的应战。很多的试验成果证明了咱们办法的有用性,分别在Road Group数据集上的1.8%的CMC-1和DukeMCMT数据集上的6.0%的CMC-1上优于最先进的办法。

网址:

https://dl.acm.org/citation.cfm?id=3351027

6.VideoRelation Detection with Spatio-Temporal Graph

作者:Xufeng Qian,Yueting Zhuang,Yimeng Li ,Shaoning Xiao,Shiliang Pu,Jun Xiao。

摘要:咱们从视觉内容中看到的不只是目标的调集,还包含它们之间的相互效果。用三元组表明的视觉联系能够传达很多信息,以供视觉了解。与静态图画不同,因为附加的时刻通道,视频中的动态联系一般在空间和时刻维度上都相关,这使得视频中的联系检测变得更杂乱和具有应战性。在本文中,咱们将视频笼统为彻底衔接的时空图。咱们运用图卷积网络运用新颖的VidVRD模型在这些3D图中传递音讯并进行推理。咱们的模型可经过时空上下文提示来更好地猜测目标及其动态联系。此外,提出了一种运用暹罗网络的在线相关办法来进行准确的联系实例相关。经过将咱们的模型(VRD-GCN)与所提出的相关办法相结合,咱们的视频联系检测结构在最新基准测验中取得了最佳功用。咱们在基准ImageNet-VidVRD数据集上验证了咱们的办法。试验成果表明,咱们的结构在很大程度上领先于最新技能,一系列的消去研讨证明了咱们办法的有用性。

网址:

https://dl.acm.org/citation.cfm?doid=3343031.3351058

7. Hierarchical Graph Semantic Pooling Network for Multi-modal Community Question Answer Matching

作者:Jun Hu,Shengsheng Qian, Quan Fang,Changsheng Xu。

摘要:现在,社区问答(CQA)体系招引了数百万用户共享其名贵的常识。为特定问题匹配相关答案是CQA体系的中心功用。曾经的根据交互的匹配办法在CQA体系中显示出令人鼓舞的功用。可是,它们一般遭到两个约束:(1)他们一般将内容建模为单词序列,而疏忽了非接连短语,远程单词依赖性和视觉信息所供给的语义。(2)单词级交互效果会集在方位上类似单词的散布上,而与问题和答案之间的语义级交互效果无关。为了处理这些约束,咱们提出了一种多层图语义池化网络(HGSPN),以在用于多模态CQA匹配的一致结构中对层次结构语义等级的交互进行建模。咱们将将文本内容转换为图形,而不是将文本内容转换为单词序列,然后能够对非接连短语和长距离单词相关性进行建模,以更好地获取语义的组成。此外,视觉内容也被建模到图中来供给弥补的语义。提出了一种规划杰出的堆叠图池网络,以根据这些图捕获问答之间的分层语义等级的交互。规划了一种新颖的卷积匹配网络,经过集成分层语义等级的交互功用来揣度匹配分数。在两个实在数据集上的试验成果表明,咱们的模型优于最新的CQA匹配模型。

网址:

https://dl.acm.org/citation.cfm?doid=3343031.3350966

产业合作推动AI发展 高通孟樸:携手伙伴共抓5G+AI新机遇

产业合作推动AI发展 高通孟樸:携手伙伴共抓5G+AI新机遇 西门子2024 Realize LIVE用户大会:拥抱新质生产力,激发数智新动能

西门子2024 Realize LIVE用户大会:拥抱新质生产力,激发数智新动能 AI技术赋能内容生产全链路 芒果探索“文化+科技”的下一步

AI技术赋能内容生产全链路 芒果探索“文化+科技”的下一步 全国人大代表刘宏志:推动数字乡村建设、激发乡村振兴“数智力量”

全国人大代表刘宏志:推动数字乡村建设、激发乡村振兴“数智力量” 情人节不止214 DR钻戒将七夕情人节传至海外

情人节不止214 DR钻戒将七夕情人节传至海外 “E动新生 旗心共创” “航价比之王”红旗E-QM5专场团购会火热爆单

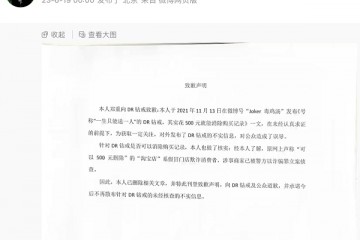

“E动新生 旗心共创” “航价比之王”红旗E-QM5专场团购会火热爆单 “DR购买记录可删”被证实是谣言,传谣者公开道歉

“DR购买记录可删”被证实是谣言,传谣者公开道歉 红旗新能源最新宠粉,E001首批盲订车主踏上“溯源之旅”

红旗新能源最新宠粉,E001首批盲订车主踏上“溯源之旅” 5月销量成绩瞩目 新能源战略引领红旗品牌再向上

5月销量成绩瞩目 新能源战略引领红旗品牌再向上 高通总法律顾问卓安琳:持续创新开放合作,助力中国伙伴在5G时代取得更

高通总法律顾问卓安琳:持续创新开放合作,助力中国伙伴在5G时代取得更