机器之心报导

机器之心编辑部

荷兰、瑞士两位学者(其间一位是教授)的SIGIR 2019论文被发现抄袭,部分内容与RecSys 2018一篇论文高度类似,只要单个用词呈现改动。

今天,有Reddit网友爆出,当选SIGIR 2019的论文《Adversarial Training for Review-based Recommendations》与RecSys 2018上的一篇论文《Why I like it: Multi-task Learning for Recommendation and Explanation》惊人类似。

起先,发帖者以为这仅仅是一个偶然,maybe 这只是由于两组研讨人员提出了相同的问题、展开了相同的研讨,然后,提出了相同的解决方案。

但仔细阅读完两篇论文后,ta 发现工作并不简略。

被质疑抄袭别人论文的两位作者别离来自荷兰和瑞士的高校。其间,Dimitrios Rafailidis 是荷兰马斯特里赫特大学的助理教授,Fabio Crestani 则来自瑞士提契诺大学。两个人是老搭档,合著过许多篇论文。Fabio Crestani 在 Google Scholar 上的被引用量乃至高达 5936。

他们的这篇论文被 SIGIR 会议接纳。SIGIR 会议的全称是「Special Interest Group on Information Retrieval」,是一个展现信息检索领域中各种新技术和新效果的重要世界论坛,在《我国核算机学会(CCF)引荐世界学术会议》列表中归于 A 类会议。

而这次抄袭事情的「原版」论文来自引荐体系顶会 ACM RecSys 2018,其间一作 Yichao Lu 是华人,现在在 AI 公司 Lyaer 6 AI 担任机器学习研讨科学家,本科就读于复旦大学,硕士就读于多伦多大学。另两位作者 Ruihai Dong 与 Barry Smyth 则来自都柏林大学。

说回来,SIGIR 2019 那篇论文中的模型像是从 RecSys 2018 那篇中仿制过来的相同,让咱们来比照一下:

首要,这两篇论文都在矩阵分化结构的基础上运用了对立序列到序列的学习模型。其次,在生成器和鉴别器的部分,两篇论文都运用了 GRU 生成器和 CNN 鉴别器。优化办法也相同,都是两个部分之前替换优化。终究,两篇论文所运用的符号和公式也极端类似……

Fine,鉴于「对立练习」是一种当下很盛行的操作,所以不能因而下结论。可是,SIGIR 2019 论文和 RecSys 2018 两篇论文的文字重合之处证明了全部:

看这两个语句,一字不差:

SIGIR 2019 论文第 1 部分。

RecSys 2018 论文第 2 部分。

在论文写作中,很难幻想一个人会写出与别人一字不差的语句,除非是抄袭的。

再来一个比如:

SIGIR 2019 论文 2.1 节:

「解码器利用了一个单一的 GRU,迭代地逐词生成谈论。具体来说,在时刻步 t 上,GRU 首要将之前时刻步的输出表征 z_ut-1 映射为 k 维向量 y_ut-1」,并将其与衔接在一同,以生成一个新的向量 y_ut。终究,将 y_ut 输入 GRU,得到躲藏表征 h_t。接下来,将 h_t 与输出投影矩阵相乘,并经过 softmax 遍历文档词汇表中的一切单词来标明每个单词的概率。时刻步 t 上的输出词 z_ut 从 softmax 给出的多项式散布中采样得到。」

RecSys 2018 论文 3.1.1 节:

「用户谈论解码器利用了一个独自的 GRU,迭代地逐词生成谈论。在时刻步 t 上,解码器 GRU 首要将前一个时刻步上的输出词 y_i, t-1 嵌入到相应的词向量,然后将其与用户文本特征向量衔接在一同。衔接后的向量被用作解码器 GRU 的输入,以获取躲藏激活 h_t。接下来,将躲藏激活与输出投影矩阵相乘,并经过 softmax 遍历文档词汇表中的一切单词来标明当时语境的每个单词的概率。时刻步 t 上的输出词 y_i, t 从 softmax 给出的多项式散布中采样得到」。

在这个比如中,SIGIR 2019 论文的作者替换了论文中的单个短语,以使两篇论文看起来没那么像。但是,发帖者以为,两篇论文之间的类似性仍是能够标明,SIGIR 2019 论文的作者在写自己的论文之前必定读过那篇 RecSys 2018 论文。

终究一个比如:

SIGIR 2019 论文 2.2 节:

「谈论 r 的每个单词都被映射成对应的词向量,然后与特定于用户的向量连在一同。需求留意的是,在 2.3 节的对立练习中,特定于用户的向量与鉴别器的参数 D_*θ*是一同学习的。接下来,用一个卷积层、最大池化层和一个全衔接映射层来处理衔接后的向量表征。CNN 的终究输出是一个 sigmoid 函数,它会将概率归一化为 [0, 1] 区间内的数字,标明候选谈论由用户 u 编撰的概率。」

RecSys 2018 论文 3.1.2 节:

「首要,将谈论中的每个词映射到相应的词向量,然后将其与一个特定于用户、标明用户信息的向量衔接在一同。特定于用户的向量与练习中的其他参数是一同学习的。接下来,用一个卷积层、最大池化层和一个全衔接层来处理衔接后的向量表征。终究的输出单元是 sigmoid 非线性,它会将概率压缩到 [0, 1] 区间内的数字。」

咱们留意到,这两段表述中有一个语句简直彻底相同(接下来,用一个卷积层……来处理衔接后的向量表征)。

别的,发帖者以为,将特定于用户的向量衔接到谈论中的每个词向量是一个十分不直观的主意。ta 标明,来自不同研讨团队的观念细节不可能如此类似。假如 ta 是作者,ta 会将特定于用户的向量衔接到终究那个投影层之前的层上,由于这样能节约核算开支,泛化功能也更好。

在整理完这些堆叠之处之后,发帖者堕入懊丧。ta 的结论是:这篇论文绝对不应该在这样一个顶会上宣布。并且此时此刻,着急的应该不只是论文作者,SIGIR 2019 的论文评定恐怕也罪责难逃了。

在谈论区,世人建议将此事奉告 SIGIR 19 会议安排·,也有人以为二位抄袭者的学术生计就此结束了。

两位作者都是闻名学府的学者,他们应该知道,剽窃在学术界是件大事。

关于科学研讨来说,观念、办法的剽窃已经是十分严峻的不端行为,更何况呈现了「仿制+张贴」这样的状况。

前段时刻由于论文抄袭而「臭名远扬」的 Siraj Raval,也是活生生的比如。由于被人扒抄袭,不只被骂得很惨,还被逼与自己兴办的 AI 学院断绝关系。

嗯,这次他也被 cue 了:

这件事的后续,恐怕会引发更多重视,不知状况是否还会发作回转。

参阅链接:

https:///r/MachineLearning/comments/dq82x7/discussion_a_questionable_sigir_2019_paper/

论文传送门:

https://gofile.io/?c=ej2y69

https://researchrepository.ucd.ie/bitstream/10197/10892/4/Why%20I%20like%20it%20Multi%20Task%20learning%20for%20recommendation%20and%20Explanation.pdf

第三届机器之心「Synced Machine Intelligence Awards」年度奖项评选正在进行中。本次评选设置六大奖项,要点重视人工智能公司的产品、使用事例和工业落地状况,根据实在客观的工业体现筛选出最值得重视的企业,为职业带来实践的参阅价值。

参选报名日期:2019 年 10 月 23 日~2019 年 12 月 15 日

评定期:2019 年 12 月 16 日~2019 年 12 月 31 日

奖项发布:2020 年 1 月

产业合作推动AI发展 高通孟樸:携手伙伴共抓5G+AI新机遇

产业合作推动AI发展 高通孟樸:携手伙伴共抓5G+AI新机遇 西门子2024 Realize LIVE用户大会:拥抱新质生产力,激发数智新动能

西门子2024 Realize LIVE用户大会:拥抱新质生产力,激发数智新动能 AI技术赋能内容生产全链路 芒果探索“文化+科技”的下一步

AI技术赋能内容生产全链路 芒果探索“文化+科技”的下一步 全国人大代表刘宏志:推动数字乡村建设、激发乡村振兴“数智力量”

全国人大代表刘宏志:推动数字乡村建设、激发乡村振兴“数智力量” 情人节不止214 DR钻戒将七夕情人节传至海外

情人节不止214 DR钻戒将七夕情人节传至海外 “E动新生 旗心共创” “航价比之王”红旗E-QM5专场团购会火热爆单

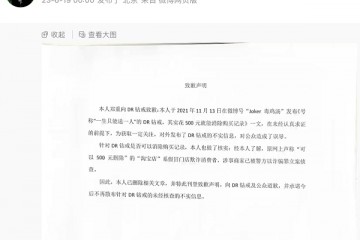

“E动新生 旗心共创” “航价比之王”红旗E-QM5专场团购会火热爆单 “DR购买记录可删”被证实是谣言,传谣者公开道歉

“DR购买记录可删”被证实是谣言,传谣者公开道歉 红旗新能源最新宠粉,E001首批盲订车主踏上“溯源之旅”

红旗新能源最新宠粉,E001首批盲订车主踏上“溯源之旅” 5月销量成绩瞩目 新能源战略引领红旗品牌再向上

5月销量成绩瞩目 新能源战略引领红旗品牌再向上 高通总法律顾问卓安琳:持续创新开放合作,助力中国伙伴在5G时代取得更

高通总法律顾问卓安琳:持续创新开放合作,助力中国伙伴在5G时代取得更